0. Abstract

- Value function은 RL에서 가장 중요한 요소중 하나입니다. 이 value function의 정의로 주로 state에 대한 이후에 받을 reward의 기댓값으로 정의합니다. 그렇기 때문에 value function을 추정해 사용하는 우리에겐 state distribution에 대한 좋은 generalization이 필요합니다. 그렇다면 state 뿐만아니라 goal에 대한 generalization을 한다면 agent에게 여러 task를 시킬 수 있지 않을까요? 이 논문에서는 이를 해결하기 위한 universal value function approximators(UVFA)를 소개합니다. 이는 Supervised learning method를 사용하여, state와 goal을 embedding하는 방법으로 unseen goal에 대해서도 잘 generalization하는 모습을 보였습니다.

1. Introduction

-

Abstract에서 생각해 보았던 것 처럼, value function을 여러 goal에 대해 확장해 생각해 보겠습니다. 하나의 goal에 대한 value function은 다음처럼 표현할 수 있습니다.

\[V_g(s)\]이를 다시 해석해보면, goal \(g\)를 달성하기 위한 state \(s\)에서의 이후의 reward의 기댓값으로 볼 수 있습니다. 이러한 value function은 environment를 이해하기 위해 어떤 방식으로든지 큰 도움이 될 수 있습니다. 이 예로 논문에서는 Horde architecture를 들었는데 자세한 내용은 인용한 논문을 링크해놓겠습니다.

Reinforcement Learning Experiments

-

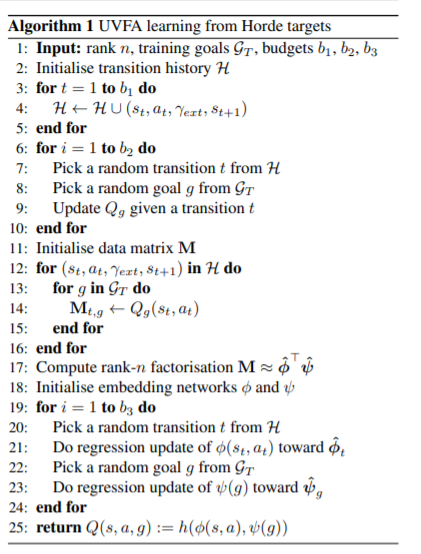

line 3-5 Q를 통해 action을 선택하고, trajectories를 만듭니다.

-

line 6-10 history로 부터 \(Q_g\) 를 학습합니다.

-

line 11-16 이를 가지고 우리는 goal과 state에 대한 표를 만들 수 있습니다.

-

line 17 그 표는 아래의 그림과 같이 state와 goal을 embedding하여 dot-product한 값들의 true value로써 regression을 통해 \(\phi\)와 \(\psi\)를 학습시킬 수 있습니다.

-

line 19-24 regression을 진행합니다.

-

line 25 이렇게 학습된 Q는 goal generalized Q가 됩니다.