Abstract

- 복잡한 objective를 reward로 표현해 agent에게 전달하는 일은 어려울 수 있습니다. 이를 해결하기 위해서 인간이 train loop에 참여하는 Human-in-the-loop(HiL) RL은 agent에게 맞춤형 feedback을 줄 순 있지만, 인간이 참여하는 자체가 큰 비용이 드는 작업인 만큼 efficiency를 높이기 위한 연구 흐름이 이어지고 있습니다. 이 논문 또한 그 맥락에 포함되는 논문입니다.

Introduction

- RL은 복잡한 일련의 행동을 배우는 강력한 도구로 떠올랐지만, 이를 실제 적용하는데에는 아직도 많은 해결해야할 점들을 가지고 있습니다. 그중 하나로 적당한 reward function을 만드는 것이 포함되어 있습니다. reward function을 통한 학습은 학습이 끝난 후 우리가 생각하는 부드럽고 자연스러운 행동, 사회적 규율을 따라야 하는 등의 행동에 대해 섬세하고 많은(어쩌면 현실적으로 불가능한) reward engineering이 필요한 작업입니다. 이 때, Imitation learning이 방법이 될 수 있으나, 이 또한 expert의 trajectories를 얻는 것이 또 어려운 점이 될 수 있습니다.

- 인간이 학습하는 과정에 대해 보면, 인간은 종종 teacher의 외부 피드백을 받아 학습합니다. 이 때 teacher를 효과적으로 만드는 점은 students와 상호작용하며 그들의 과정에 따라 그들이 필요한 점을 짚어줄 수 있다는 것입니다. 이러한 상호작용을 통한 학습은 agent의 learning에도 매력적인데 이는 reward engineering없이 teacher의 preference에만 의존해 agent를 학습시킬 수 있기 때문입니다. 하지만 적용되는 분야에 한계가 있고 아직 널리 적용되는 방법론은 아닙니다.

- 이 연구에서는 HiL에서 인간의 노력을 줄이는 방법에 대해 설명합니다. 이는 unsupervised PrE-training and preference-Based Learning via relaBeLing Experience(PEBBLE)로, 두 가지 시너지를 내는 Unsupervised-learning과 Off-policy learning로 구성됩니다. 자세한 방법은 뒤에서 설명합니다.

- Contribution

- Unsupervised pre-training과 off-policy learning을 통해 sample- and feedback-efficiency를 높혔습니다.

- PEBBLE은 기존의 preference-based RL baseline을 다양한 benchmark에서 뛰어 넘었습니다.

- PEBBLE은 reward function engineering이 어려운 작업에 대해 학습함을 보였습니다.

- PEBBLE은 environment의 reward 사용없이 바라는 행동을 할 수 있음을 보였습니다.

Related Work

- Learning from human feedback

- 기존에 feedback이 모든 time step에 가능할 때에 대해 연구들이 이루어졌으나, 확장성에 대한 문제가 있습니다.

- reward function을 classifier로 배우는 연구들이 있었습니다.

- regression을 통해 배우는 방향도 있었으나, 특정 행동에 대해 인간이 신뢰성있게 value를 제공하기는 어려운 면이 있었습니다.

- 사람이 preference를 제공하는 방법 중 쉬운 방법의 하나로, 어떤게 좋고 나쁜지 비교해 전달하는 방법이 있습니다. 그렇기 때문에 이런 방법의 preference-based learning은 감독은 쉽지만 전달가능한 정보가 많아 매력적입니다. 이 방향의 비슷한 맥락으로 sample efficiency를 높이기 위한 연구들이 이루어졌었습니다.

- Unsupervised pre-training for RL - 기존의 주어진 task를 수행하기 전 학습을 효율적으로 하기 위해 이뤄진 unsupervised pre-training으로써 prediction error나 cont-based state novelty, mutual information, state entropy 등이 들어간 intrinsic reward를 maximize하는 method들이 연구되었습니다.

Prelimiaries

- Reinforcement learning

- Soft Actor-Critic

- Reward learning from preferences

-

segment는 \(\sigma\)로 표현합니다. 이는 적당한 길이의 sequence \(\{s_k,a_k,..., s_{k+H},a_{k+H}\}\)를 포함하고 있습니다. preference는 \(y\)로 한 쌍의 segments에 대해 다음과 같은 값을 가지고 있습니다 \(y \in \{ (0,1), (1,0), (0.5,0.5)\}\). Dataset에 preference data는 다음과 같이 저장됩니다\((\sigma^0, \sigma^1, y)\). preference predictor는 다음과 같은 reward function \(\hat{r}_{\psi}\)을 사용해 표현합니다.

\[P_\psi [\sigma^1 \succ \sigma^0] = \frac{\exp{\sum_t{\hat{r}_\psi}(s^1_t,a^1_t)}}{\sum_{i \in\{0,1\}}\sum_t{\hat{r}_\psi}(s^i_t,a^i_t)}\]\(\sigma^i \succ \sigma^j\)는 segment i가 segment j 보다 preferable하다는 뜻입니다. \(\hat{r}_{\psi}\)는 binary classifier가 아니지만, \(\hat{r}_{\psi}\)를 학습하는 것은 인간에게 주어진 preference y를 가지고 binary classification하는 것과 같이 학습할 수 있습니다. 결과적으로 reward function의 parameter \(\psi\)는 다음을 minimize하는 방법으로 학습됩니다.

\[L^{\mathrm{Reward}} = - \mathbb{E}_{(\sigma^0, \sigma^1, y) \sim \mathcal{D}}[y(0)\log{P_\psi[\sigma^0 \succ \sigma^1]} + [y(1)\log{P_\psi[\sigma^1 \succ \sigma^0]}]\]

-

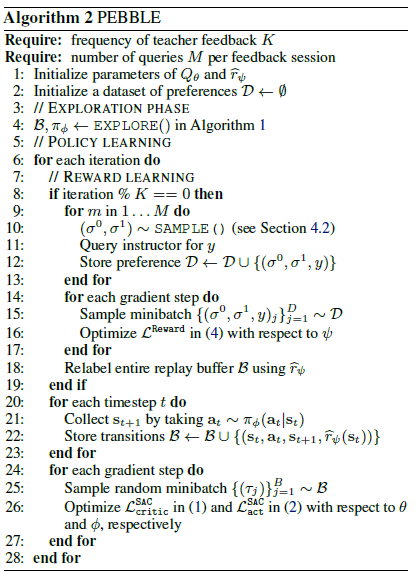

PEBBLE

- 이번 section에서는 PEBBLE에 대해 본격적으로 설명하는데, 그전에, policy, Q-function, reward function은 각각 \(\pi_\phi, Q_\theta, \hat{r}_{\psi}\)로 표현합니다.

- Step 0 : \(\pi_{\phi}\)를 intrinsic reward를 통해 unsupervised pre-training시킵니다.

- Step 1 : \(\hat{r}_\psi\) 를 학습시킵니다.

- Step 2 : off-policy method인 SAC을 통해 \(\pi_\phi\)와 \(Q_\theta\)를 학습시킵니다. 그리고, reward의 non-stationary함을 해소합니다.

- Repeat Step 1 and Step 2 until converge

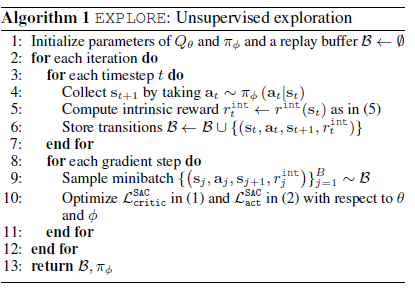

- Accelerating Learning via Unsupervised Pre-training

- Unsupervised pre-training을 통해, teacher에게 의미있는 query를 보낼 수 있도록 합니다. 본문에선 state entropy를 intrinsic reward로, 이를 maximize하는 방식을 통해 environment를 효과적으로 explore하고 다양한 behavior를 만들도록 합니다. 하지만 실제 state entropy를 다루는 것이 intractable하므로, 다음과 같은 entropy estimator를 통해 intrinsic reward를 구합니다.

\(\hat{\mathcal{H}}\)는 각각의 \(s_i\)에 대한 k번째 가까운 states들과의 거리에 비례하는데, 각 state와 가까운 state들의 거리를 크게 만들수록 전체적인 state의 entropy가 커진다는 의미입니다. intrinsic reward는 다음으로 정의합니다.

\[r^{\mathrm{int}}(s_t) = \log{(||s_t - s^k_t)||}\]sample과 replay buffer내의 sample에 대한 k-NN distance를 구하고, intrinsic reward는 running estimate of the standard deviation으로 나누어집니다. 전체적인 알고리즘은 다음과 같습니다.

- Selecting Informative Queries

- 이상적으로, expected value of information(정보가치의 기댓값)을 maximize하기 위해 preference를 query하는 것이 이상적이겠지만, 이는 현실적으로 intractable하므로, 기존 연구에서 사용한 sampling scheme과 함께 제시합니다. 첫 째로 uniform sampling, 둘 째로, ensemble-based sampling으로 sensemble reward model에서 가장 varience가 높은 segments pair를 선택하는 방법, 셋 째로 entropy-based sampling으로decision boundary에서 가장 애매한 쌍을 찾는 방법으로, 많은 segment pairs를 뽑아 이중 \(\mathcal{H}(P_{\psi})\)를 가장 maximize하는 쌍을 선택하는 방법이 있고 Experiments에서 이 sampling들을 실험합니다.

- Using Off-policy RL with Non-Stationary Reward

- reward function이 학습중에 계속 update되므로, 기존의 replay buffer에 있는 data와 reward가 달라 \(\hat{r}_\psi\)가 non-stationary할 수 있음을 보인 연구가 있습니다. 그렇기 때문에 기존까지 On-policy TRPO등으로 이를 해결했으나, On-policy의 한계로 sample-efficiency가 낮다는 한계가 있습니다. 본문에서는 replay buffer에 label된 reward를 reward model이 update될 때마다 relabel함으로써 이를 해결하였습니다. 그리하여 PEBBLE의 전체 algorithm을 pseudo-code로 나타내자면 다음과 같습니다.

Experiments

- 기존의 method들과 차이외에도 본문에서 나온 sampling방법들, novel behavior에 대해 학습시킬 수 있는지등에 대해 나와있으므로 관심있다면 보시는 것을 추천드립니다.